生成AI(ジェネレーティブAI)は、ビジネスの生産性を飛躍的に向上させる可能性を秘めていますが、その強力な能力の裏には看過できない「問題点」や「リスク」が潜んでいます。

技術的な課題から法的な論点、セキュリティの脅威まで、その内容は多岐にわたります。安易な導入は、企業の信頼を揺るがす重大なインシデントにつながりかねません。

しかし、リスクを正しく理解し、適切な対策を講じることは、AIを安全な形で自社の競争力へと昇華させるための第一歩です。

この記事では、AI活用を検討するすべてのビジネスパーソンに向けて、生成AIが抱える主要な問題点を体系的に整理し、日本政府や公的機関の公式見解、そして企業が取るべき具体的な対策までを網羅的に解説します。

- 生成AIが抱える主要な7つのリスク(技術的、法的、セキュリティ)

- 日本政府や公的機関が示す公式なリスク見解と主要ガイドライン

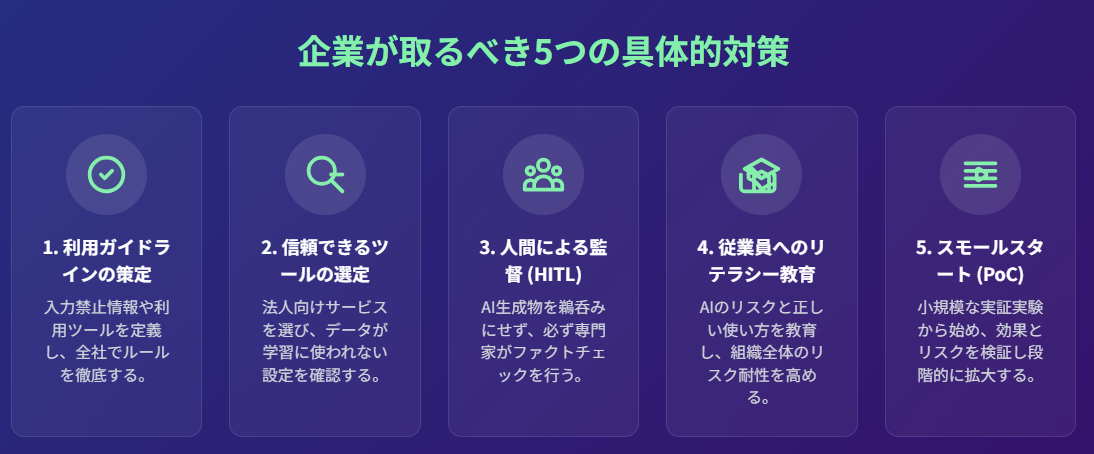

- 企業がAIを安全に活用するために取るべき5つの具体的な対策

1.生成AIの光と影 – なぜ今「問題点」を知るべきなのか

2024年、生成AIは特定の専門家だけのものではなく、あらゆるビジネス現場で活用が検討される普遍的なテクノロジーとなりました。

電子情報技術産業協会(JEITA)は、生成AIの世界市場が2030年には2,110億ドル(約30兆円)に達すると予測しており、この巨大な波に乗り遅れまいと多くの企業が導入を急いでいます。

マーケティングコンテンツの自動生成、ソフトウェア開発の効率化、議事録の自動作成など、その活用範囲は日々拡大し、生産性向上の「光」の部分が注目されています。

しかし、その輝かしい光の裏には、濃い「影」が存在します。

AIが生成した事実に基づかない情報(ハルシネーション)、著作権侵害のリスク、そして機密情報の漏洩など、事業の根幹を揺るがしかねない問題点が指摘されています。

本質を理解しないまま流行に乗ってAIを導入することは、羅針盤なくして荒波の海に乗り出すようなものです。

本記事は、生成AIを活用する上での「問題点」を明確にし、それらに対する具体的な対策を示すことを目的としています。

これにより、皆様がリスクを効果的に管理し、AIをビジネス成長の力に変えるための道筋をご提案します。

参照:電子情報技術産業協会(JEITA)|生成AI市場の世界需要額見通しを発表

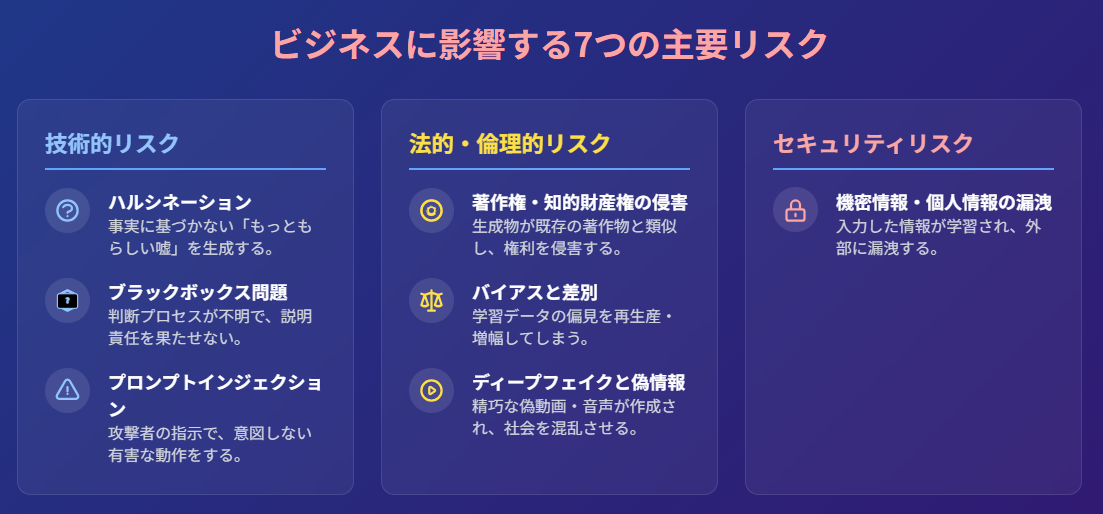

2.ビジネスに影響する、生成AIの主要な7大リスク

まず、本記事で掘り下げる主要な問題点を一覧でご紹介します。

これらのリスクは相互に関連しあっていますが、本質を理解するために「技術的リスク」「法的・倫理的リスク」「セキュリティリスク」の3つのカテゴリーに分類して解説します。

- ハルシネーション(もっともらしい嘘)の発生

- 思考プロセスのブラックボックス化と説明責任の問題

- プロンプトインジェクションによる意図しない動作

- 著作権・知的財産権の侵害

- 学習データに起因するバイアスと差別的表現

- ディープフェイクと偽情報(フェイクニュース)の拡散

- 機密情報・個人情報の漏洩

3.技術的リスク|生成AIが本質的に抱える3つの課題

まず、生成AIというテクノロジーそのものが内在する、避けては通れない技術的な問題点を見ていきましょう。

① ハルシネーション(もっともらしい嘘)の発生

ハルシネーションとは、AIが事実に基づかない情報を、あたかも真実であるかのように、もっともらしく生成する現象のことです。

LLM(大規模言語モデル)が、次に続く確率が高い単語を予測して文章を生成するという仕組みに起因するため、本質的にこのリスクをゼロにすることは困難です。

ビジネスシーンにおいて、AIが生成した誤った市場データや存在しない判例を基に意思決定を下した場合、その損害は計り知れません。

②思考プロセスのブラックボックス化と説明責任の問題

AI、特にディープラーニングを基盤とするモデルは、なぜその結論に至ったのか、人間が理解できる形で論理的な理由を説明するのが難しいという「ブラックボックス問題」を抱えています。

これは「説明可能なAI(XAI)」という研究分野で解決が試みられていますが、いまだ発展途上です。

金融機関の融資判断や、人事評価といった重要な場面でAIの判断を用いる場合、その結論に至った根拠を説明できないことは、顧客や従業員からの信頼を損なうだけでなく、法的な説明責任を果たせないリスクにもつながります。

③プロンプトインジェクションによる意図しない動作

プロンプトインジェクションとは、攻撃者が巧妙に細工した指示(プロンプト)を入力することで、AIの安全機能(ガードレール)を回避し、開発者が意図しない有害な応答や不正な動作を引き起こさせるサイバー攻撃の一種です。

例えば、顧客対応チャットボットに特殊な指示を与えることで、非公開の割引情報を漏洩させたり、差別的な発言をさせたりする事例が報告されています。

これは、AIシステムのセキュリティにおける新たな脆弱性として認識されています。

4.法的・倫理的リスク|コンプライアンスを揺るがす3つの課題

次に、企業のコンプライアンスや社会的信用に直結する、法的・倫理的な問題点です。

これらは国や地域によって法整備の状況が異なるため、グローバルに事業展開する企業は特に注意が必要です。

④著作権・知的財産権の侵害

生成AIが学習データとしてインターネット上の膨大なコンテンツを利用する際、そこに著作物が含まれている可能性があります。

そして、AIが生成したコンテンツが既存の著作物と類似してしまった場合、意図せず著作権を侵害してしまうリスクがあります。

日本の著作権法第30条の4では、AI開発のための学習利用は原則として著作権者の許諾なく可能とされていますが、「著作権者の利益を不当に害する場合」は例外とされており、その解釈は依然として議論が続いています。

また、AI生成物そのものが著作物として保護されるためには、プロンプトの工夫など人間による「創作的寄与」が必要とされるのが一般的です。

参照:e-Gov 法令検索|第三十条の四

文化庁|AIと著作権に関する考え方について

⑤学習データに起因するバイアスと差別的表現

AIは、学習したデータに含まれる社会的な偏見やステレオタイプ(バイアス)を再生産、増幅してしまう可能性があります。

例えば、過去の採用データに性別による偏りがあった場合、AIが特定の性別に不利な選考結果を出してしまうといったケースが考えられます。

このようなAIによる差別は、企業の評判を著しく損なうだけでなく、人権侵害として法的な問題に発展する可能性も秘めています。

⑥ディープフェイクと偽情報(フェイクニュース)の拡散

画像生成AIや音声合成AIの進化は、特定の人物が言ってもいないことを話しているかのような、非常に精巧な偽動画(ディープフェイク)の作成を容易にしました。

競合企業のCEOに関するネガティブなフェイク動画を流布して評判を貶めたり、企業の財務責任者になりすましたディープフェイク音声で詐欺を行ったりする事例も報告されており、偽情報の拡散は深刻な社会・経済リスクとなっています。

5.セキュリティリスク|企業の生命線を脅かす重大な課題

最後に、企業の最も重要な資産である「情報」を脅かす、セキュリティ上のリスクです。

⑦機密情報・個人情報の漏洩

従業員が業務の効率化のために、企業の機密情報(新製品の開発情報、財務データなど)や、顧客の個人情報を含む文章を、安易に外部の生成AIサービスに入力してしまうケースが後を絶ちません。

多くのAIサービスでは、入力された情報がAIモデルのさらなる学習に利用される可能性があり、それが意図せず他のユーザーへの回答として出力され、情報が漏洩するリスクがあります。サムスン電子で発生したソースコード漏洩事件は、その典型的な事例です。

6.政府・公的機関はリスクをどう見ているか?主要ガイドラインを徹底解説

生成AIのリスクは、個別企業だけでなく国家レベルの課題として認識されており、日本の政府・公機関も様々なガイドラインを公表しています。

ここでは、その中から特に重要なものを抜粋し、国が示す公式な方向性を解説します。

デジタル庁:「行政における利用ガイドライン」の要点

デジタル庁は、主に行政機関向けですが、民間企業にも参考となる「生成AIの利活用に関するガイドライン」を策定しています。

この中では、情報漏洩リスクへの対策として、機密情報を扱う際は入力情報の学習利用をオフにできる機能を持つツールの利用や、そもそも機密情報を入力しないといった基本的なルール遵守を徹底するよう求めています。

参照:「行政の進化と革新のための生成AIの調達・利活用に係るガイドライン」を策定しました – デジタル庁

総務省・経済産業省:「AI事業者ガイドライン」が示す方向性

両省が共同で策定した「AI事業者ガイドライン」は、AIの開発者、提供者、利用者がそれぞれ留意すべき事項をまとめています。

特に「人間の尊重」「安全性」「公平性」「プライバシー保護」「セキュリティ確保」「透明性」「責任」といった原則を掲げ、企業が自主的にAIガバナンスを構築することの重要性を説いています。

参照:令和6年版 情報通信白書|生成AIが及ぼす課題 – 総務省

IPA:「AI利用時のセキュリティ脅威」に関する公式報告

独立行政法人情報処理推進機構(IPA)は、AI利用におけるセキュリティリスクについて詳細な調査報告書を公開しています。

報告書では、プロンプトインジェクションやデータ漏洩といった脅威を具体的に解説し、企業が実施すべきリスクアセスメントや多層的な防御策の必要性を強調しています。

参照:IPAテクニカルウォッチ「AI利用時のセキュリティ脅威・リスク調査報告書」

文部科学省:「教育現場での利用」に関する注意点

文部科学省は、教育現場向けのガイドラインを公表しており、その中で生成AIに安易に頼ることによる学生の思考力低下や、レポート盗用といった倫理的な問題点を指摘しています。これは、企業における人材育成の観点からも示唆に富む内容です。

参照:初等中等教育段階における生成AIの利活用に関するガイドライン-文科省

7.生成AIのリスクに企業はどう立ち向かうべきか?5つの具体的対策

ここまで問題点を解説してきましたが、ただ恐れるだけではAI時代の競争から取り残されてしまいます。

リスクを管理し、安全に活用するための具体的な対策を5つご紹介します。

1. 社内利用ガイドラインの策定と周知徹底

最も基本的かつ重要な対策は、全従業員が遵守すべき明確なルールを定めることです。

- 入力して良い情報、禁止する情報(個人情報、機密情報など)の定義

- 業務で利用を許可するAIツールの指定

- 問題が発生した際の報告手順

これらのルールを策定し、全社的に研修を行うなどして周知を徹底することが不可欠です。

2. 信頼できるツール選定とセキュリティ設定の確認

法人利用を前提とした、セキュリティレベルの高いエンタープライズ向けのAIサービスを選定しましょう。

具体的には、入力データを学習に利用しない(オプトアウト)設定が可能であることや、アクセス管理機能が充実していることなどが重要な選定基準となります。

3. ファクトチェックと人間による監督(Human-in-the-Loop)プロセスの導入

AIの生成物は、決して鵜呑みにしてはいけません。

特に外部公開するコンテンツや、重要な意思決定に利用する情報については、必ず専門知識を持つ人間が事実確認(ファクトチェック)を行うプロセスを業務フローに組み込むべきです。

この「Human-in-the-Loop(HITL)」は、AIの誤りを是正し、品質を担保するための生命線です。

4. 従業員へのAIリテラシー教育の実施

全従業員を対象に、AIの仕組み、リスク、そして適切な使い方に関するリテラシー教育を行うことが極めて重要です。

従業員一人ひとりが「AIは間違いを犯す可能性がある」という前提に立ち、責任を持ってツールを使いこなす意識を醸成することが、組織全体のリスク耐性を高めます。

5. 「スモールスタート」と段階的な活用範囲の拡大 (PoCの実施)

いきなり全社的に大規模な導入を目指すのではなく、まずは影響範囲の少ない特定の部門や業務で、小規模な実証実験(PoC:概念実証)から始めることを強く推奨します。

PoCを通じて、リスクや費用対効果を具体的に検証し、学びを得ながら段階的に活用範囲を広げていくアプローチが、最終的な成功確率を大きく高めます。

8.リスクの理解こそ、責任あるAI活用への第一歩

本記事では、生成AIが抱える7つの主要な問題点と、それらに対する公的機関の見解、そして企業が取るべき実践的な対策について解説しました。

ハルシネーション、著作権侵害、情報漏洩といったリスクは、決して無視できるものではありません。しかし、これらの課題は、AI活用を断念させるための障害ではなく、私たちが乗り越えるべきマイルストーンです。

重要なのは、生成AIの問題点を深く理解することが、単なるリスク回避のための消極的な活動ではなく、AIを自社の真の競争力へと昇華させるための、最も重要で戦略的な第一歩であると認識することです。

社内ガイドラインを策定し、従業員教育を行い、人間による監督プロセスを組み込む。

こうした地道なガバナンス体制の構築こそが、AIという強力なテクノロジーを安全に使いこなし、持続的な成長を実現する唯一の道筋と言えるでしょう。

リスクへの理解を、ぜひ「責任あるイノベーション」への力強い一歩に変えてください。